In Kürze: Anti-Muster der gefühlten KI-Präzision

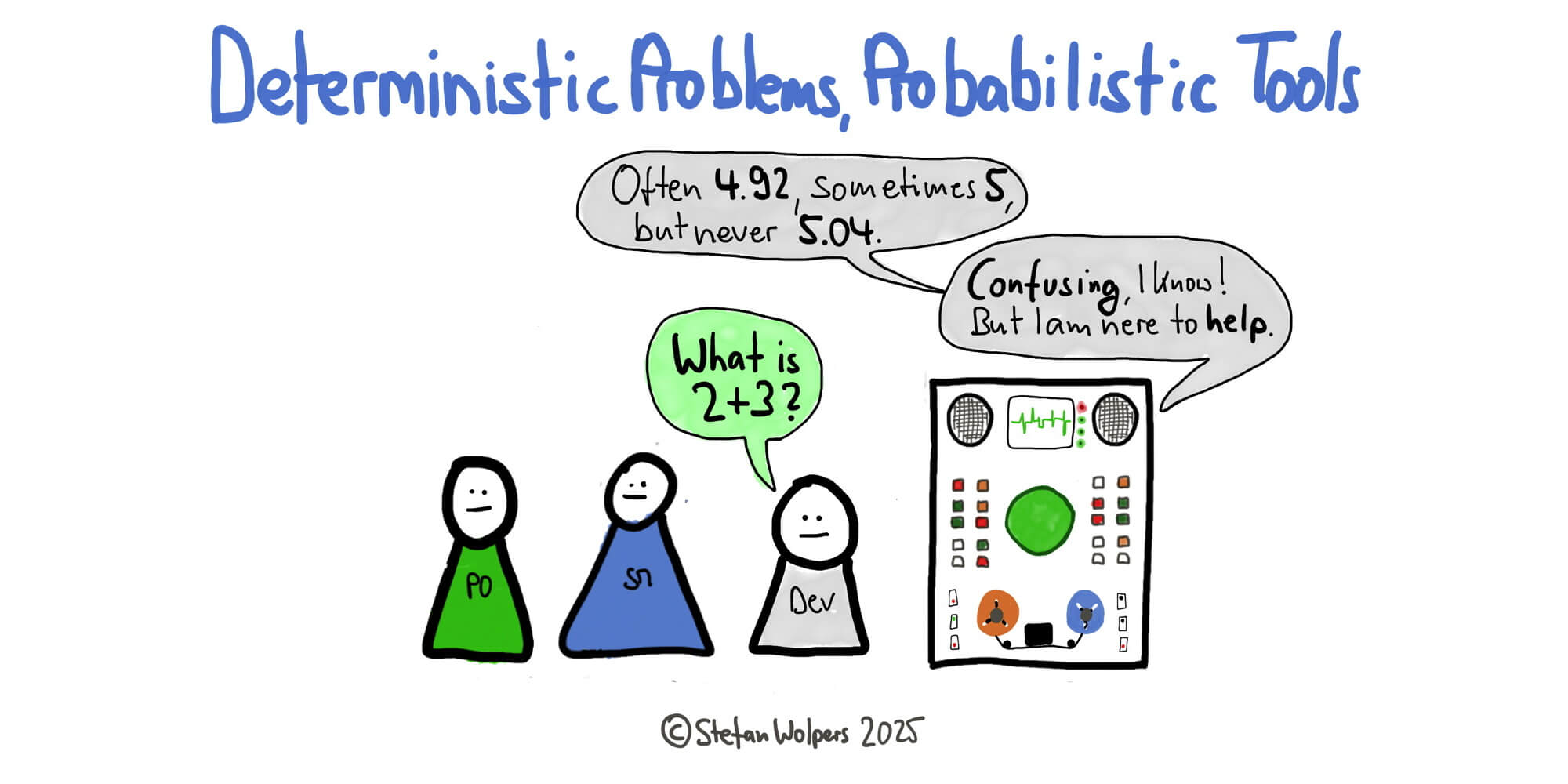

Hier ist ein weiteres Beispiel für Ihre Sammlung: Das Anti-Muster der KI-Präzision oder Organisationen, die LLMs für deterministische Probleme verwenden, obwohl eine KI auf LLM-Basis von Natur aus ein probabilistisches Werkzeug ist. Kommt Ihnen das bekannt vor? Es ist das gleiche Muster, das wir beobachten, wenn Teams Cargo-Cult-Praktiken von „Agile“ kultivieren, ohne deren Zweck zu verstehen.

LLMs eignen sich hervorragend zur Textzusammenfassung und Mustererkennung in großen Datensätzen, was u.a. bei der Analyse von Benutzerfeedback oder der Erstellung von Dokumentationsentwürfen hilfreich ist. Die eigentliche Frage ist jedoch eine andere: Können Sie Ihre KI auch für deterministische Aufgaben wie Berechnungen verwenden? Wenn Sie Ihr Werkzeug nicht sorgfältig auf das Problem abstimmen, bauen Sie am Ende alle möglichen Herausforderungen in das Fundament Ihres Produkts ein.

Was können Sie dagegen tun? Spoiler-Alarm: Die Lösung liegt nicht in einem besseren Prompting, sondern in der Anpassung der Auswahl Ihrer genutzten Werkzeuge an die Aufgabenstellung.

Ihr LLM ist nicht defekt; Sie verwenden es nicht korrekt.

In der Produktentwicklung zeichnet sich ein neues Verhalten ab: die Verwendung generativer KI für Aufgaben, die 100 % Genauigkeit und Konsistenz erfordern. Während LLMs leistungsstarke Werkzeuge für die Ideenfindung, Mustererkennung oder Zusammenfassung sind, stellt ihre Verwendung als Taschenrechner oder Compiler jedoch einen Missbrauch der Technologie dar.

Dieser Ansatz führt zu einer systemischen Unzuverlässigkeit Ihres Produkts und zeugt von einem Missverständnis hinsichtlich des Verwendungszwecks des Tools. Bei deterministischen Problemen ist diese Strategie nicht nur ineffizient, sondern führt auch direkt zum Scheitern.

Der Kern des Anti-Musters KI-Präzision

Im Grunde genommen entsteht dieses Anti-Muster durch eine grundlegende Diskrepanz zwischen dem Problem und dem Werkzeug:

- Ein deterministisches Problem hat eine und nur eine richtige Antwort. Bei identischer Eingabe muss jedes Mal genau das gleiche Ergebnis erzielt werden. Denken Sie an das Kompilieren von Code, das Ausführen einer Datenbankabfrage oder das Berechnen der Umsatzsteuer. Dies unterliegt einer strengen, überprüfbaren Logik.

- Ein probabilistisches System, wie beispielsweise ein LLM, arbeitet hingegen mit statistischer Wahrscheinlichkeit. Es wird die plausibelste Wortfolge auf der Grundlage seines Trainings prognostiziert. Sein Ziel ist es, eine überzeugende, menschenähnliche Antwort zu generieren, nicht eine überprüfbar richtige.

Die Verwendung eines LLM für eine deterministische Aufgabe ist vergleichbar mit der Beauftragung eines Autors mit der Erstellung Ihrer Steuererklärung. Sie erhalten wahrscheinlich ein Dokument, das gut strukturiert ist und kompetent klingt. Die Wahrscheinlichkeit, dass es numerisch korrekt ist und den Steuergesetzen entspricht, ist jedoch gering. Der gleiche Effekt tritt auf, wenn Sie ein Tool, das für Kreativität und Gewandtheit entwickelt wurde, für eine Aufgabe einsetzen, die strikte Präzision erfordert.

Fehlerarten, denen Sie begegnen werden

Wenn Teams in die Falle der KI-Präzision tappen, zeigen sich die Folgen in vorhersehbarer Weise, die die Produktqualität und das Vertrauen der Nutzer untergraben:

Plausible, aber falsche Ergebnisse (Halluzinationen)

Der häufigste Fehler tritt auf, wenn das LLM selbstbewusst eine falsche Antwort liefert. Es kann Code generieren, der syntaktisch einwandfrei ist, aber einen subtilen, kritischen Logikfehler enthält. Oder es beantwortet die Berechnungsanfrage eines Benutzers mit einer Zahl, die korrekt erscheint, aber faktisch falsch ist. Das Modell lügt nicht, es stellt lediglich eine statistisch wahrscheinliche Folge von Tokens zusammen, ohne dass diese auf faktischer Genauigkeit beruhen.

Inkonsistente Ergebnisse

Ein Kernprinzip jedes zuverlässigen deterministischen Systems ist die Wiederholbarkeit. Ein LLM verstößt hingegen wegen seiner Konzeption gegen dieses Prinzip. Aufgrund seiner probabilistischen Natur und seiner Stichprobenverfahren kann die mehrmalige Stellen derselben Frage zu unterschiedlichen Antworten führen. Dieser Grad an Unzuverlässigkeit ist für jeden Prozess, der konsistente, vorhersehbare Ergebnisse erfordert, inakzeptabel. Auf einer instabilen Grundlage kann man keine stabile Funktionalität aufbauen.

Nicht überprüfbare „Argumentation”

Wenn ein LLM seine „Gedankenkette” erklärt, legt es keinen formalen Beweis vor. Es generiert eine Erzählung, die seinen probabilistischen Weg zur Antwort erklärt. Diese Begründung ist selbst wiederum eine probabilistische Vermutung und kann nicht formal überprüft werden. Im Gegensatz zu einem Compiler-Fehler, der auf eine bestimmte Codezeile verweist, bietet die Erklärung eines LLM keine Garantie für logische Korrektheit.

Verwenden Sie das richtige Werkzeug für die jeweilige Aufgabe

Die Feststellung, dass die Verwendung probabilistischer Werkzeuge zur Lösung deterministischer Probleme eine Herausforderung darstellt, bedeutet nicht, dass generative KI keine revolutionäre Technologie ist. Sie eignet sich hervorragend für Aufgaben, die Kreativität, Zusammenfassung, Brainstorming und natürliche Sprachinteraktion erfordern, und beweist täglich ihren Wert für agile Praktiker.

Die Lösung für dieses grundlegende Missverhältnis zwischen Fähigkeiten und Anforderungen besteht nicht darin, die Genauigkeit des LLM bei deterministischen Aufgaben „zu korrigieren”. Vielmehr muss man den grundlegenden Unterschied zwischen den beiden Problemtypen erkennen und seine Systeme entsprechend gestalten:

- Verlassen Sie sich für Präzision, Genauigkeit und Überprüfbarkeit auf deterministische Tools: Tabellenkalkulationen, Compiler oder Datenbankmanagementsysteme.

- Betrachten Sie LLMs eher als ergänzende Tools und nicht als Ersatz. Die effektivsten Anwendungen kombinieren die Mustererkennungsfähigkeiten des LLM mit traditionellen, logikbasierten Systemen, die die präzise Berechnung und Überprüfung übernehmen.

Für Produkt- und Entwicklungsteams ist die Lösung daher einfach: Wählen Sie das Werkzeug anhand der Aufgabe aus. Das simple Ersetzen eines deterministischen Modells durch ein probabilistisches Modell ist keine Innovation, sondern ein Anti-Muster, das unnötige Risiken und technische Schulden in Ihr Produkt einführt.

Fazit: Das Anti-Muster der KI-Präzision

Dieses KI-Anti-Muster deckt ein systemisches Problem bei der Einführung neuer Technologien auf: Wir stürzen uns gern auf das Neue, ohne unsere tatsächlichen Beschränkungen zu hinterfragen.

Genauso wie Scrum scheitert, wenn Teams seine empirischen Grundlagen ignorieren, scheitern LLM-Implementierungen, wenn wir die probabilistische Natur der aktuellen KI-Systeme ignorieren. Die Organisationen, die mit KI erfolgreich sind, sind nicht diejenigen, die KI überall einsetzen, sondern diejenigen, die diszipliniertes Produktdenken praktizieren. Sie verstehen, dass bahnbrechende Technologien ein gebührendes Urteilsvermögen darüber erfordern, wann sie nicht eingesetzt werden sollten.

🗞 Soll ich Sie über Artikel wie diesen informieren? Großartig! Sie können sich hier für den Newsletter „Food for Agile Thought“ anmelden und sich über 40.000 Abonnenten anschließen.