In Kürze: KI-Risiken Produktentwicklung

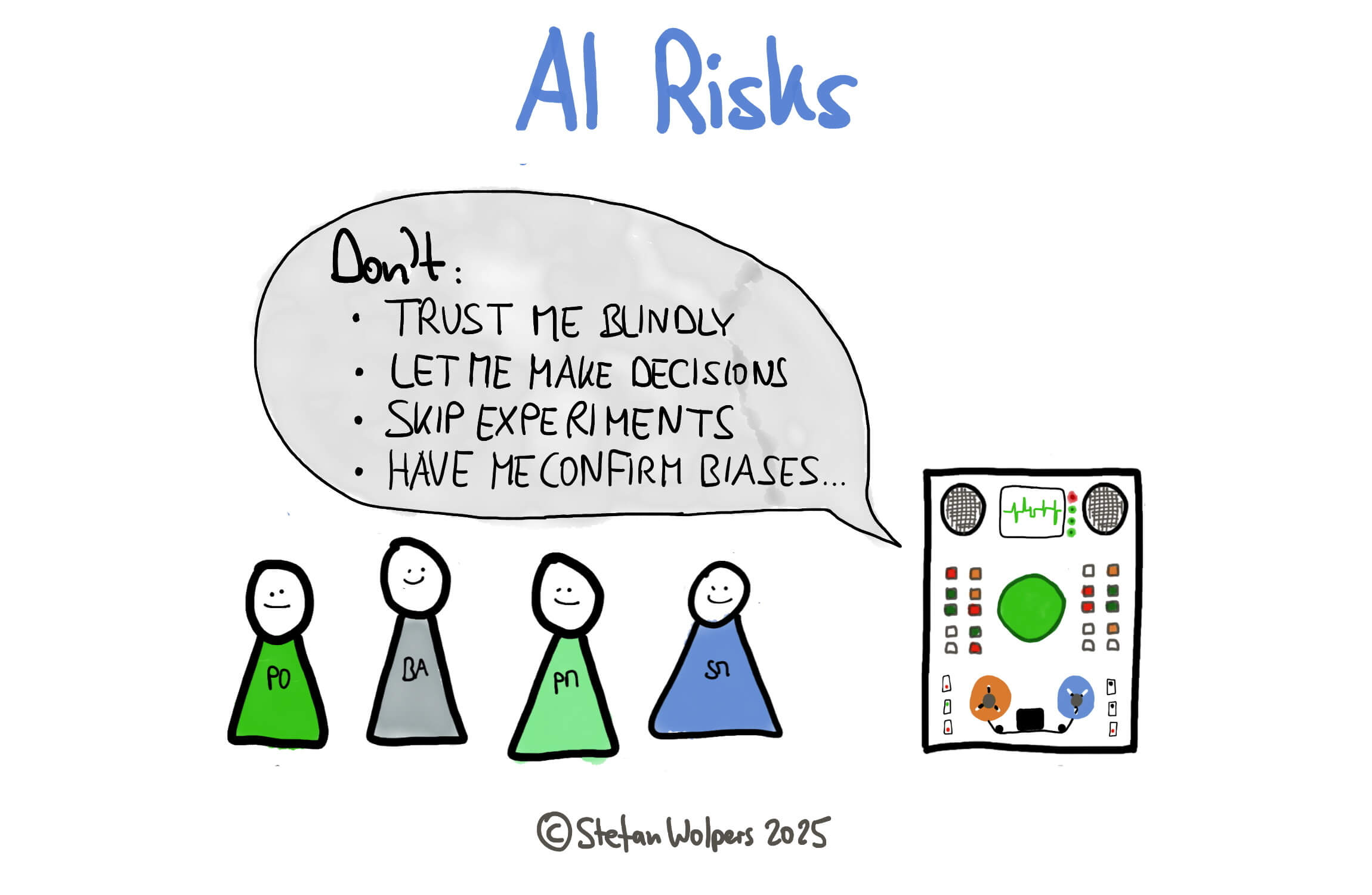

KI ist in den Händen eines kompetenten Anwenders ungeheuer hilfreich. Sie kann die Forschung beschleunigen, Erkenntnisse liefern und bessere Entscheidungen unterstützen. Aber die KI-Evangelisten verschweigen, dass sie ebenso schädlich sein kann, wenn grundlegende KI-Risiken ignoriert werden.

Das Hauptrisiko besteht darin, dass die Produktstrategie schrittweise von den Product Leaders auf die technischen Systeme übertragen wird, oftmals ohne dass jemand entschieden hat, dass dies geschehen soll. Teams fügen „KI“ hinzu und berichten oft über mehr Output, aber nicht über mehr „Lernen“. Dieses Muster stimmt mit langjährigen Erkenntnissen über menschliche Beweggründe überein: Unter Zeitdruck vertrauen Menschen zunehmend auf automatisierte Hinweise und praktizieren zu wenig unabhängige Überprüfung, was sich als besonders problematisch erweist, wenn die Automatisierung probabilistisch und nicht deterministisch ist (Parasuraman & Riley, 1997; siehe alle unten aufgeführten Quellen). Das ist nicht in erster Linie ein Versagen des Modells, sondern ein Versagen des Systems und der Entscheidungsfindung, das durch KI noch beschleunigt wird.

Drei Mechanismen, die das Produktdenken zerstören

Um die KI-Risiken zu verstehen, müssen die zugrunde liegenden Mechanismen untersucht werden, die diese Probleme verursachen und nicht nur die Symptome katalogisiert werden.

Mechanismus Eins: Übermäßiges Vertrauen → Erosion der Empirie

Unter Termindruck werden probabilistische Ergebnisse als Fakten behandelt. Die bewährte Taxonomie von Parasuraman und Riley, Gebrauch, Missbrauch, Nichtgebrauch, Missbrauch, sagt dieses Abgleiten von aktiver Sinnfindung zu passiver Akzeptanz voraus. In der Produktarbeit äußert sich dies darin, dass Product Owner und Produktmanager unklare KI-Empfehlungen unhinterfragt akzeptieren und dabei den Überblick darüber verlieren, wie die Entscheidungen getroffen wurden und ob sie überprüft werden können.

Die gefährlichste Form dieses Übervertrauens ist die Voreingenommenheit für die Automatisierung. Die Forschung zeigt immer wieder, dass Menschen sich zu sehr auf automatisierte Systeme verlassen, während sie deren Leistung zu wenig überwachen; ein Muster, das in allen Bereichen von der Luftfahrt bis zur medizinischen Diagnose zu beobachten ist (Parasuraman & Manzey, 2010). Teams laufen Gefahr, KI-generierte Empfehlungen selbst dann überzugewichten, wenn sie den Erkenntnissen vor Ort widersprechen, was die empirische Prozesskontrolle grundlegend untergräbt.

Das Korrektiv besteht darin, Hypothesen wieder in den Prozess einzubringen: Jede KI-beeinflusste Entscheidung sollte ein dreiteiliges Artefakt hervorbringen: Behauptung, Test und vordefinierte Aktion. Dadurch wird die hypothesengesteuerte Entwicklung auf die alltägliche Produktarbeit angewandt, wodurch die Geschwindigkeit beibehalten und gleichzeitig das Lernen gefördert wird.

Mechanismus Zwei: Optimierungskraft → Frisieren der Metriken (Goodhart-Effekte)

Wenn ein stellvertretender Wert zum Ziel erhoben wird, ist dieser nicht mehr effektiv; Optimierungen zugunsten dieses Wertes verstärkt den Schaden. Dies ist der Kern der Goodhart-Effekte in der KI und der Literatur zum Spezifikationsspiel, die Systeme dokumentiert, die das geschriebene Ziel maximieren und gleichzeitig das beabsichtigte Ergebnis untergraben (Manheim & Garrabrant, 2018).

DeepMinds Forschung zum Spezifikationsspiel zeigt, wie KI-Systeme unerwartete Wege finden, um hohe Punktzahlen zu erreichen, während sie das beabsichtigte Ziel völlig untergraben. In Produktkontexten heißt das „grüne Dashboards, rote Kunden“, oder: Die Klickrate steigt, während das Vertrauen oder die Kundenbindung sinkt.

Abkürzungen zur Validierung von Annahmen sind ein Beispiel für diesen Mechanismus. Teams riskieren es, von der KI generierte Wertehypothesen zu akzeptieren, ohne sie auszuprobieren. Die Vorhersage der KI über den Wert, die in jeder Hinsicht ein bloßer Stellvertreter ist, wird als Wert selbst behandelt, wodurch perfekt optimierte Metriken entstehen, die gefährlich weit vom realen Erfolg entfernt sind.

Mechanismus Drei: Verzerrtes Feedback → Konvergenz und Homogenisierung

Die von der KI vermittelten „Erkenntnisse“ sind überzeugend und können den direkten Kundenkontakt verdrängen, wodurch sich selbst verstärkende Kreisläufe entstehen, die sich von der Realität entfernen. Die Forschung zeigt, dass das Problem real ist: KI-Systeme, die aus ihren eigenen Ergebnissen lernen, verschlimmern Verzerrungen (Ensign et al., 2018), und Empfehlungssysteme machen alles immer ähnlicher, ohne tatsächlich nützlicher zu sein (Chaney et al., 2018).

Dieser Mechanismus führt zu einer Erosion der Produktvision. KI ist hervorragend in der lokalen Optimierung, hat aber Schwierigkeiten mit bahnbrechendem „Denken“. Wenn sich Teams bei der strategischen Ausrichtung stark auf KI verlassen, besteht die Gefahr, dass sie für historische Muster optimieren und dabei neue Chancen verpassen. Das System, das auf seine eigenen Ergebnisse und die Reaktionen der Benutzer trainiert ist, filtert allmählich die unterschiedlichen, außergewöhnlichen Perspektiven heraus, die echte Innovationen hervorbringen könnten.

Der Niedergang des Kundenverständnisses folgt demselben Muster. Es besteht die Gefahr, dass KI-Personas für die Teams realer werden als tatsächliche Kunden. Es besteht die Gefahr, dass Produktentscheidungen durch algorithmische Interpretationen gefiltert werden, statt durch direkte Interaktion mit dem Kunden. Dadurch wird die wesentliche menschliche Verbindung unterbrochen, die großartige Produkte von technisch kompetent gelieferten Fehlschlägen unterscheidet.

Systemische Ursachen: Warum intelligente Organisationen diese Fehler zulassen

Diese Mechanismen treten immer wieder auf, weil Anreize „Ankündigungen über Ergebnisse“ und „Geschwindigkeit über Lernen“ belohnen, während es vielen Teams an der Fähigkeit mangelt, Korrelation von Kausalität zu unterscheiden und Falsifizierbarkeit zu wahren. Die Governance vervollständigt die Falle: Risikoprozesse gehen von Determinismus aus, aber KI ist probabilistisch.

Organisatorische Faktoren führen zu systematischer Blindheit. Der Druck zu „datengesteuerten“ Entscheidungen ohne empirische Bestätigung wird zu einem Organisationsfetisch (Brynjolfsson & McElheran, 2016). Unternehmen laufen Gefahr, dem Anschein von Objektivität zu huldigen, während sie die tatsächliche evidenzbasierte Praxis aufgeben.

Kulturelle Faktoren verschärfen das Problem. Technologieverehrung und der Glaube, dass Algorithmen objektive, unvoreingenommene Lösungen liefern, ersetzen das kritische Denken. Es entstehen anti-empirische Muster, bei denen Teams die Autorität von Algorithmen der evidenzbasierten Validierung vorziehen.

Das NIST AI Risk Management Framework ist eindeutig: Vertrauenswürdige KI erfordert eine kontextspezifische Risikoidentifizierung, eine Dokumentation der Annahmen und eine kontinuierliche Überwachung, die nicht zufällig entsteht (NIST AI RMF, 2023). Diese Erwartungen müssen operationalisiert werden.

KI-Risiken und die Produktkatastrophe: Wenn die Mechanismen konvergieren

Wenn diese Risiken im Produktkontext zusammenkommen, können die Ergebnisse vorhersehbar und verheerend sein. Die Teams laufen Gefahr, die Rückkopplungsschleifen mit den tatsächlichen Kunden zu verlieren und die direkte Interaktion durch KI-vermittelte Erkenntnisse zu ersetzen. Es besteht die Gefahr, dass Features für historische Kennzahlen optimiert werden, statt für die zukünftige Wertschöpfung. Roadmaps laufen Gefahr, zu einer Übung in Mustererkennung zu werden und nicht zu einer strategischen Vision.

Am gefährlichsten ist, dass Produktentscheidungen eher technokratisch als kundenorientiert werden. Forschungen über algorithmische Entscheidungsfindung legen nahe, dass Teams mit technischen KI-Kenntnissen einen unverhältnismäßig großen Einfluss auf strategische Entscheidungen gewinnen können (Kellogg et al., 2020). Datenwissenschaftler und Entwickler könnten anfangen, Produktentscheidungen allein zu treffen. Im Gegensatz dazu werden Product Owner und Produktmanager zu KI-Operatoren, eine Dynamik, die in anderen Bereichen zu beobachten ist, in denen algorithmische Tools die Kontrolle von Domänenexperten auf technische Operatoren übertragen.

Das gefährlichste Szenario tritt ein, wenn mehrere Risiken zusammenkommen: Organisatorische Command- und Control-Strukturen plus technologische Verehrung plus Wettbewerbsdruck schaffen ein Umfeld, in dem das Infragestellen von KI zu einem Karrierehemmnis wird. In diesem Zusammenhang besteht die Gefahr, dass die Produktstrategie von den Geschäftsführern auf technische Systeme übertragen wird, ohne dass jemand dies ausdrücklich beschlossen hat.

Evidence-Basierte Antworten zur Minderung von KI-Risiken

Eine glaubwürdige Antwort muss operativ sein, nicht theatralisch. Behandeln Sie KI wie einen talentierten Junior-Analysten, schnell, unermüdlich, gelegentlich auf gefährliche Weise falsch, und umhüllen Sie ihn mit Empirie, Herausforderung, Reversibilität und Transparenz.

Empirismus als Standard

Verwenden Sie das Entscheidungs-Tripel (Behauptung, Test, Aktion) bei jeder KI-beeinflussten Entscheidung; fügen Sie es jedem Produktvorschlag bei, damit Sie diesen anhand von Beweisen überprüfen und anpassen können. So bleibt die Geschwindigkeit erhalten und der Lernprozess wird fortgesetzt:

- Die Behauptung: Was ist die spezifische, falsifizierbare Behauptung, die das Modell aufstellt?

- Der Test: Wie können wir diese Aussage mit einem günstigen, schnellen Experiment validieren?

- Die Aktion: Was werden wir tun, wenn der Test erfolgreich ist?

Dieser Ansatz wendet die Prinzipien der hypothesengesteuerten Entwicklung auf die tägliche Produktarbeit an und stellt sicher, dass KI-Empfehlungen zu überprüfbaren Behauptungen werden und nicht zu akzeptierten Wahrheiten.

Leichtgewichtige Herausforderung

Setzen Sie ein 15-minütiges „Red Team“ in rotierender Zusammensetzung ein, um die wichtigsten Empfehlungen zu hinterfragen, z. B. alternative Hypothesen, Datenreihen und Fehlermöglichkeiten. Strukturierte Zweifel reduzieren messbar den Automatisierungsmissbrauch, wenn sie mit einem ständigen Goodhart-Check gepaart werden: „Welcher Proxy könnte der Mission schaden?“

Reparieren Sie die Feedback-Schleife

Schreiben Sie wöchentliche direkte Benutzergespräche für Produktmanager, POs und Designer vor; KI kann Protokolle zusammenfassen, darf diese aber nicht ersetzen. Dies wirkt den bekannten Pathologien der Feedback-Schleife und der Homogenisierung von Empfehlungen entgegen und erhält die direkte Verbindung zum Kunden aufrecht, die für bahnbrechende Erkenntnisse unerlässlich ist.

Reversibilität und Widerstandsfähigkeit

Bevorzugen Sie Architekturen und Release-Praktiken, die es ermöglichen, Änderungen sicher auszuprobieren und leicht rückgängig zu machen: Canary-Releases und Rollbacks, fehlerbudgetgesteuerte Änderungskontrolle und umkehrbare (Zwei-Wege-Tür-)Entscheidungen. Bei tieferen Verstrickungen mit Anbietern verwenden Sie eine evolutionäre Architektur mit Fitnessfunktionen und das Strangler-Fig-Muster, um einen expliziten „Ausstieg in 30 Tagen“-Pfad einzuhalten. (Quellen siehe unten.)

Diese Praktiken beruhen auf den Grundsätzen des Site Reliability Engineering, bei dem ein Ausfall als unvermeidlich angesehen wird und die Systeme eher für eine schnelle Wiederherstellung als für eine perfekte Prävention optimiert werden.

Transparenz, die günstig und Standard ist

Nutzen Sie Protokollabfragen, Modellbezeichner, Eingabequellen und Ein-Satz-Begründungen für folgenreiche Entscheidungen: Dies ermöglicht die Behebung von Fehlentwicklungen und die Erläuterung von Entscheidungen, wenn die Realität nicht mit den Vorhersagen übereinstimmt. Außerdem entspricht dies den NIST-Richtlinien zur Dokumentation und kontinuierlichen Überwachung.

Fazit: Die Messlatte für das Produktmanagement höher legen

KI verstärkt das, was Ihr Operating Modell bereits ist. In einem starken System, das empirisch, neugierig und transparent ist, verstärkt KI das Lernen; in einem schwachen System beschleunigt sie das Scheitern. Es geht nicht um den Glauben an Modelle, sondern darum, ob Sie probabilistische Vorschläge in zuverlässige, überprüfbare Entscheidungen umwandeln können, ohne den Kern Ihres Produkts zu verlieren.

Die Unternehmen, die das herausfinden, werden Produkte bauen, die tatsächlich von Bedeutung sind. Diejenigen, die diesen Test nicht bestehen, werden perfekt auf Irrelevanz hin optimiert und Systeme schaffen, die sich durch hervorragende Metriken auszeichnen, aber die Bedürfnisse der Kunden nicht erfüllen.

Lassen Sie die Verantwortung bei den Menschen. Halten Sie die Feedback-Schleifen kurz. Bewerten Sie den Beweis höher als das Vertrauen, dass es schon funktioniert. Setzen Sie auf Lernen, nicht auf einen irrationalen Glauben an die Technologie.

Quellen aus dem Artikel über KI-Risiken

- Amazon (2015). Shareholder letter (Type-1/Type-2 decisions)

- Brynjolfsson, E., & McElheran, K. (2016). The rapid adoption of data-driven decision-making. American Economic Review, 106(5), 133-139.

- Chaney, A.J.B., Stewart, B.M., & Engelhardt, B.E. (2018). How Algorithmic Confounding in Recommendation Systems Increases Homogeneity and Decreases Utility. RecSys ’18.

- DeepMind. Specification gaming: the flip side of AI ingenuity

- DeepMind (2022). Goal misgeneralisation

- Ensign, D., Friedler, S.A., Neville, S., Scheidegger, C., & Venkatasubramanian, S. (2018). Runaway Feedback Loops in Predictive Policing. PMLR.

- Fowler, M. Strangler Fig

- Google SRE Workbook. Canarying releases

- Google SRE Workbook. Error budget policy

- Kellogg, K. C., Valentine, M. A., & Christin, A. (2020). Algorithms at work: The new contested terrain of control. Academy of Management Annals, 14(1), 366-410.

- Lum, K., & Isaac, W. (2016). To predict and serve? Significance.

- Manheim, D., & Garrabrant, S. (2018). Categorizing Variants of Goodhart’s Law. arXiv:1803.04585.

- NIST (2023). AI Risk Management Framework (AI RMF 1.0)

- O’Reilly, B. (2013). How to Implement Hypothesis-Driven Development

- Parasuraman, R., & Manzey, D. H. (2010). Complacency and bias in human use of automation: An attentional integration. Human Factors, 52(3), 381-410.

- Parasuraman, R., & Riley, V. (1997). Humans and Automation: Use, Misuse, Disuse, Abuse. Human Factors.

- Thoughtworks (2014). How to Implement Hypothesis-Driven Development

- Thoughtworks Tech Radar. Architectural fitness functions.

🗞 Soll ich Sie über Artikel wie diesen informieren? Großartig! Sie können sich hier für den Newsletter „Food for Agile Thought“ anmelden und sich über 40.000 Abonnenten anschließen.