In Kürze: Wie Ihr Vorteil zu Ihrer Achillesferse wird

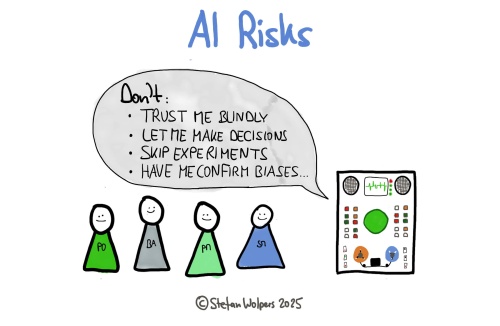

KI kann Ihr Produktmodell still und leise aushöhlen, indem Sie empirische Validierungen durch Musterabgleiche und algorithmische Entscheidungen ersetzt. Dieser Artikel und sein zugehöriges Video über die KI-Risiken in der Produktentwicklung zeigt drei konsolidierte Risikokategorien und praktische Grenzen auf, um ein kundenorientiertes Urteilsvermögen zu bewahren und gleichzeitig KI effektiv zu nutzen.

📺 Jetzt das Video ansehen: Product Development AI Risks: When Your Leverage Becomes Your Liability.

Drei grundsätzliche KI-Risiken in der Produktentwicklung

KI ist in den Händen eines geschickten Akteurs ungeheuer hilfreich. Sie ist ein gewaltiger Hebel, der Ihnen zur Verfügung steht.

Allerdings kann das Ignorieren grundlegender Risiken ebenso schädlich sein. Ihre Pflicht? Bilden Sie sich weiter. Lassen Sie mich hierzu die wichtigsten Risikokategorien aus der Produktperspektive aufschlüsseln.

Drei grundsätzliche Risiken

In den meisten Diskussionen über KI-Risiken in der Produktarbeit werden eher mehrere sich überschneidende Symptome als eindeutige Grundursachen genannt. Ich habe drei grundlegende Fehlermuster identifiziert, die von Bedeutung sind:

1. Den Weg zur Validierung abkürzen: Wenn Sie aufhören, Experimente durchzuführen

Dieses Risiko kombiniert das, was oft als „Automatisierungsverzerrung“ und „Abkürzungen bei der Wertvalidierung“ bezeichnet wird, aber es handelt sich um dasselbe Problem: Die Akzeptanz von KI-Ergebnissen ohne empirische Tests.

Erinnern Sie sich daran, wie Sie Produktanforderungen in Hypothesen, dann in Testkarten, Experimente und schließlich in Lernkarten verwandeln? Große Sprachmodelle eignen sich hervorragend dafür, weil es sich um eine Aufgabe handelt, bei der Muster erkannt werden. Sie können schnell plausible Ergebnisse erzeugen.

Das Problem liegt jedoch auf der Hand: Sie fangen an, am Anfang zurückhaltend, dann offensiver, die Hypothese Ihres Modells zu akzeptieren, ohne richtige Experimente durchzuführen. Warum sollten Sie nicht „sparen“, wenn das Management glaubt, dass Sie mit KI 25-50% mehr mit dem gleichen Budget erreichen können?

So überspringen Sie die Validierung. Die KI hat Tausende von Support-Tickets analysiert und Ihnen „gesagt“, was die Kunden wollen. Das klingt datengesteuert. Aber KI optimiert innerhalb Ihres bestehenden Kontexts und Ihrer Daten. Praktisch gesehen optimieren Sie Ihre Blase, ohne zu erkennen, dass es außerhalb dieser Blase enorme Möglichkeiten geben könnte. KI sagt Ihnen, welche Muster in Ihrer Vergangenheit existieren. Sie kann hingegen nicht bestätigen, was in Ihren Daten noch nicht kodiert ist.

2. Die Kurzsichtigkeit in Sachen Produktvision: Verpassen Sie bahnbrechende Chancen

KI optimiert lokal auf der Grundlage Ihres Kontexts und der verfügbaren Daten. Sie ist brillant bei inkrementellen Verbesserungen innerhalb bestehender Beschränkungen, versagt aber bei der Erkennung von bahnbrechenden Chancen außerhalb Ihrer aktuellen Marktposition.

Die „Erosion der Produktvision“ geschieht also allmählich. Jede KI-Empfehlung fühlt sich vernünftig an. Jede Optimierung liefert messbare Ergebnisse. Aber Sie sind zunehmend auf dem Holzweg: Sie werden besser in etwas, das in achtzehn Monaten vielleicht keine Rolle mehr spielt.

Dieses Risiko liegt in der rückwärtsgewandten Natur der KI begründet, nicht darin, wie Sie sie einsetzen.

3. Die Abkopplung vom Menschen: Wenn Algorithmen das Urteilsvermögen ersetzen

Drei häufig genannte Risiken kommen hier zusammen. Sie haben zugelassen, dass KI Ihre Verbindung zu den Menschen, deren Probleme Sie lösen, interpretiert und übersetzt:

- Verwässerung der Verantwortlichkeit: Wenn KI-beeinflusste Entscheidungen fehlschlagen, wer ist dann verantwortlich? Der Product Owner befolgte „datengesteuerte Best Practices“. Der Datenwissenschaftler hat eine Analyse erstellt. Die Führungskraft hat die Einführung von KI veranlasst. Niemand ist für das Ergebnis unmittelbar verantwortlich.

- Einbindung der Stakeholder ersetzt: Anstelle des direkten Dialogs verwenden Sie KI, um den Input der Stakeholder zu analysieren. Sie verlieren dabei den Menschen, den Gesichtsausdruck, die Pause, die verrät, was jemand wirklich meint.

- Verschlechterung des Kundenverständnisses: KI-Personas werden realer als tatsächliche Kunden. Entscheidungen werden eher technokratisch als kundenorientiert.

Das sind nicht drei Probleme. Es sind die Symptome einer Krankheit: Der Algorithmus steht jetzt zwischen Ihnen und den Menschen, deren Probleme Sie lösen sollen.

Warum diese Risiken entstehen

Wir können diese Risiken auf drei Kategorien zurückführen:

- Menschliche Faktoren: Kognitive Faulheit. Selbstüberschätzung bei der Erkennung von KI-Problemen. Die Angst durch KI ersetzt zu werden, was zu einer übermäßigen Akzeptanz oder Ablehnung führt.

- Organisatorische Faktoren: Druck für „datengesteuerte“ Entscheidungen ohne Validierung. Unklare Grenzen zwischen KI-Empfehlungen und Ihrer Verantwortlichkeit.

- Kulturelle Faktoren: Technologieverehrung. Anti-empirische Muster, die Autorität über Beweise stellen.

Die systemische Gefahr

Wenn mehrere Faktoren zusammenkommen, wie hier in einer Befehls- und Kontrollkultur, die unter Wettbewerbsdruck steht und gleichzeitig die Technologie anbetet, wird das Hinterfragen von KI karrierehemmend augelegt.

Das Ergebnis? Die Produktstrategie wird von den Führungskräften der Unternehmen auf die technischen Systeme übertragen, oft ohne dass jemand darüber formell entscheidet.

Ihre Verantwortung

Sie bleiben für die Produktergebnisse verantwortlich, nicht die KI. Hier sind drei Praktiken, die sicherstellen, dass das auch so bleibt:

- Keine Abkürzungen bei der Validierung nehmen: Behalten Sie die empirische Validierung aller KI-Empfehlungen bei. Behandeln Sie KI-Ergebnisse als Hypothesen, nicht als endgültige Feststellungen.

- Gegen Visionsverwässerung: Nutzen Sie die KI, um die Ausführung zu optimieren, aber behalten Sie das menschliche Urteil über die Richtung bei. Fragen Sie: Was ist für die KI unsichtbar, weil es nicht bereits in unseren Daten enthalten ist?

- Gegen die Abkopplung vom Menschen: Behalten Sie den direkten Kundenkontakt und das Engagement mit den Stakeholders bei. Stellen Sie die Ergebnisse der KI immer in Frage, insbesondere wenn sie Ihre Annahmen bestätigen. (Sie können dies übrigens auch automatisieren.)

Die Praktiker, die erfolgreich sind, werden nicht diejenigen sein, die KI am schnellsten einführen. Sie werden diejenigen sein, die die klarsten Grenzen zwischen der Nutzung der KI-Fähigkeiten und der Auslagerung ihres Urteilsvermögens wahren.

Schauen Sie sich das komplette Video an, um diese Risiken anhand weiterer Beispiele zu erkunden und zu erfahren, was schief geht, wenn Teams diese Grundlagen ignorieren.

Schlussfolgerung

Die Unterscheidung zwischen KI-Nutzung als Hebel Ihrer Fähigkeiten und Outsourcen Ihres Urteilsvermögens an die KI entscheidet darüber, ob Sie die Verantwortung behalten oder die Produktstrategie stillschweigend auf Algorithmen übertragen.

Ihre Verpflichtung bleibt unverändert: Validieren Sie empirisch, sprechen Sie direkt mit Kunden und hinterfragen Sie Ergebnisse, die Ihre bestehenden Annahmen bestätigen.

Was tun Sie, um KI-Risiken in der Produktentwicklung zu vermeiden?

🗞 Soll ich Sie über Artikel wie diesen informieren? Großartig! Sie können sich hier für den Newsletter „Food for Agile Thought“ anmelden und sich über 40.000 Abonnenten anschließen.