In Kürze: Die A3-Handoff-Canvas

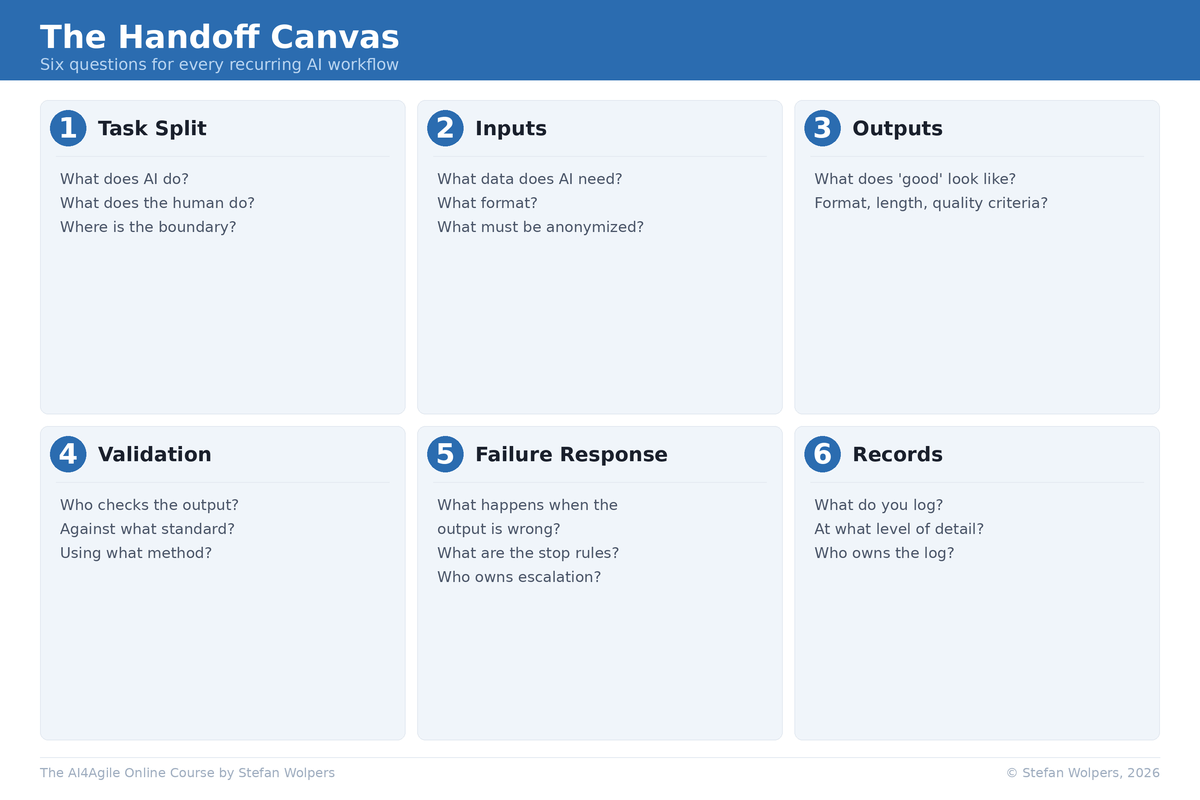

Das A3-Framework unterstützt Sie bei der Entscheidung, ob KI eine Aufgabe übernehmen sollte (Assist, Automate, Avoid). Der A3-Handoff-Canvas deckt dabei das ab, was Teams oft übersehen: wie man die Übergabe ohne Qualitäts- oder Verantwortlichkeitsverlust durchführt. Es handelt sich um eine sechsteilige Workflow-Vereinbarung für den wiederkehrenden Einsatz von KI: Aufgabenteilung, Eingaben, Ausgaben, Validierung, Fehlerbehandlung und Dokumentation. Wenn Sie einen dieser Teil nicht schriftlich festhalten können, werden sich dort Fehler und Ausreden einschleichen.

Der A3-Handoff-Canvas schließt eine Lücke in einem nützlichen Muster: von einem unstrukturierten Prompt über die Anwendung des A3-Frameworks zur Dokumentation von Entscheidungen mit dem A3-Handoff-Canvas bis hin zur Erstellung übertragbarer Skills, die möglicherweise zum Aufbau von Agenten führen.

Sie haben die Frage der Delegation gelöst. Allerdings beginnen nun Probleme aufzutreten.

Das A3-Framework bietet Ihnen ein KI-Entscheidungssystem: Unterstützen, Automatisieren oder Vermeiden. Praktiker, die es übernommen haben, haben damit aufgehört, erst zu prompten und dann zu denken.

Gut, das war der Sinn der Sache.

Aber ein Muster wiederholt sich immer wieder. Zum Beispiel entscheidet der Scrum Master, dass das Verfassen einer Zusammenfassung der Sprint-Reviews für Stakeholder, die nicht teilnehmen konnten, in die Kategorie „Unterstützen” fällt. Also fordert er Claude auf, einen Entwurf zu erstellen, bearbeitet ihn und verschickt ihn. Es funktioniert. Beim dritten Sprint fragt ein Kollege: „Wie haben Sie das gemacht? Ich möchte das auch so machen.” Und der Scrum Master kann seinen eigenen Prozess nicht so erklären, dass jemand anderes ihn wiederholen könnte.

Der Prompt befindet sich irgendwo in einem Chat-Fenster. Der Kontext war in seinem Kopf. Die Validierung lautete: „Erscheint mir das korrekt?“.

Die Form der Lösung

Betrachten wir zunächst das Gesamtbild, bevor wir die einzelnen Elemente des A3-Handoff-Canvas durchgehen. Sechs Teile, von denen jeder eine Entscheidung erfordert, die Sie nicht überspringen können:

- Aufgabenteilung: Was leistet die KI? Was leistet der Mensch? Wo liegt die Grenze?

- Eingaben: Welche Daten benötigt die KI? In welchem Format? Was muss anonymisiert werden?

- Ausgaben: Wie sieht ein „gutes” Ergebnis aus? Was sind die Kriterien für Format, Länge und Qualität?

- Validierung: Wer überprüft die Ergebnisse? Anhand welcher Standards? Mit welcher Methode?

- Fehlerbehandlung: Was geschieht, wenn die Ergebnisse fehlerhaft sind? Welche Stoppregeln gelten?

- Aufzeichnungen: Was wird protokolliert? Wie detailliert? Wem verantwortet die Protokolle?

Als verantwortungsbewusster agiler Praktiker haben Sie eine einfache Aufgabe: Füllen Sie einen Canvas pro bedeutenden KI-Workflow aus; nicht pro Prompt, sondern pro wiederkehrenden Workflow.

Wann Sie den Canvas nicht verwenden sollten: Bei einmaligen Prompts, persönlichen Produktivitätsaufgaben mit geringem Risiko und in Situationen, in denen die Kosten für die Dokumentation das Risiko übersteigen. der Canvas ist für wiederkehrende Workflows gedacht, mit denen sich Fehler ausbreiten können oder andere Personen von den Ergebnissen abhängig sind.

Zu vermeidendes Anti-Muster: Canvases nachträglich ausfüllen, um bereits getroffene Entscheidungen zu rechtfertigen. Dies ist Governance-Theater. Wenn der A3-Handoff-Canvas Ihre Arbeitsweise nicht verändert, erfüllen Sie lediglich Compliance-Anforderungen, anstatt sie zu leben.

Die Daten bestätigen, dass dies kein Einzelfall ist. In unserem AI4Agile Practitioners Report (n = 289) geben 83 % der Befragten an, KI-Tools zu verwenden, aber 55,4 % verbringen 10 % oder weniger ihrer Arbeitszeit mit KI, und 85 % haben keine formelle Schulung zum Einsatz von KI in agilen Kontexten erhalten [2]. Die Akzeptanz ist breit, aber oberflächlich. Die meisten Praktiker experimentieren ohne Struktur, und die Kluft zwischen „Ich nutze KI” und „Ich habe einen wiederholbaren Arbeitsablauf” ist der Punkt, an dem Qualität und Verantwortlichkeit verloren gehen.

Dell’Acqua et al. (2025) fanden in einer kontrollierten Umgebung ein ähnliches Muster: Personen, die mit KI arbeiteten, erreichten die Leistung eines Zweierteams, aber mit unausgereiften Prompts und nicht optimierten Tools bezeichneten die Forscher ihre Ergebnisse bestenfalls als eine „untere Grenze“.

Wie man den A3-Handoff-Canvas einsetzt

Lassen Sie uns alle sechs Felder des A3-handoff-Canvas durchgehen:

1. Aufgabenteilung: Wer macht was?

Wenn Sie die Abgrenzung nicht festhalten, wird die menschliche Seite stillschweigend zum „Lektor”.

Zweck: Machen Sie beide Seiten explizit: Was macht die KI, was macht der Mensch, wem gehört das Ergebnis?

Was ist zu entscheiden:

- Welche konkrete Aufgabe übernimmt die KI? (Nicht „hilft bei”, sondern eine konkrete, überprüfbare Handlung.)

- Welche konkrete Aufgabe übernimmt der Mensch? (Nicht „überprüft”, sondern was Sie überprüfen und anhand welcher Kriterien.)

- Wem gehört das Endergebnis, wenn ein Stakeholder es in Frage stellt?

Beispiel: „Die KI erstellt einen Entwurf für eine Sprint-Review-Zusammenfassung aus dem Jira-Export, strukturiert nach dem Sprintziel. In Zusammenarbeit mit dem Product Owner wählt der Scrum Master aus, welche Elemente aufgenommen werden sollen, fügt eine qualitative Bewertung hinzu und entscheidet, was extern geteilt und was teamintern bleiben soll.”

Häufiger Fehler (‚Assist‘ als bloße Absegnung): Praktiker definieren die Aufgabe der KI, lassen jedoch die Aufgabe des Menschen vage. „Ich überprüfe es“ ist keine Aufgabendefinition. Wenn die menschliche Seite vage ist, verkommt Assist zu Copy-Paste: Sie haben es als Assist klassifiziert, behandeln es jedoch wie Automate ohne Audit-Rhythmus, wodurch Ihr kritisches Denken mit der Zeit erodiert. Jedes Mal, wenn Sie es versäumen, Ihr Urteilsvermögen einzubringen, wird dieser Muskel geschwächt. Die Praktiker in unserer AI4Agile 2026-Umfrage, die sich Sorgen um KI machen, befürchten nicht, durch diese ersetzt zu werden, sondern den Verlust ihrer Fähigkeiten, die ihr Urteilsvermögen wertvoll machen [2].

2. Eingaben: Was wird eingegeben?

Die meisten Praktiker überspringen diesen Punkt, weil sie glauben, dass die Eingaben offensichtlich sind. Das ist jedoch nicht der Fall. Eingaben ändern sich im Laufe der Zeit und gelegentlich auch über Nacht, wenn Tools aktualisiert werden.

Zweck: Legen Sie fest, welche Daten die KI benötigt, in welchem Format und was ausgeschlossen werden muss.

Was ist zu entscheiden:

- Welche Datenquellen? (Jira-Export, Besprechungsnotizen, Slack-Thread-Zusammenfassungen, Transkripte von Kundeninterviews.)

- Welches Format? (CSV, eingefügter Text, hochgeladenes Dokument, strukturierte Eingabeaufforderungsvorlage oder RAG.)

- Was muss anonymisiert oder ausgeschlossen werden, bevor es in ein KI-Tool gelangt?

strong="">„Die Eingabe ist ein CSV-Export aus Jira, gefiltert nach dem aktuellen Sprint, sowie dem Text des Sprintziels aus den Sprint-Planungsnotizen. Kundennamen werden vor dem Hochladen durch Segmentkennungen ersetzt.“

Häufiger Fehler (einmal einrichten und vergessen ‚Automate‘): Teams definieren Eingaben einmalig und überprüfen sie anschließend nicht mehr. Wenn Ihre Eingabespezifikation sechs Monate alt ist und sich Ihre Tools zweimal geändert haben, basiert Ihr Automatisierungs-Workflow auf veralteten Annahmen. Automatisierung funktioniert nur, wenn Sie Regeln festlegen und Ergebnisse überprüfen. Andernfalls kommt es zu einer unsichtbaren Abweichung.

3. Ergebnisse: Was bedeutet „gut“?

Die folgenden fünf Prüfungen sind die Standard-Qualitätsmaßstäbe innerhalb des Elements „Ergebnisse“ des Canvas. Passen Sie sie an Ihren Kontext an, um der häufigsten Täuschung bei KI-gestützten Arbeiten zu entgehen: „Ich erkenne ein gutes Ergebnis, wenn ich es sehe.“

- Genauigkeit: Tatsachenbehauptungen lassen sich auf eine Quelle zurückführen. Die Zahlen stimmen mit den Eingabedaten überein.

- Vollständigkeit: Enthält alle in Ihrem Output-Element definierten Pflichtangaben.

- Zielgruppengerecht: Ist für die angegebene Zielgruppe geschrieben (nicht-technische Stakeholder, teamintern, Führungsebene).

- Tonfall: Neutral, keine Schuldzuweisungen, keine Versuche, die Tatsachen zu verdrehen, keine Marketing-Sprache, wenn eine Analyse angefordert wurde.

- Risikobehandlung: Ungewisse Punkte werden gekennzeichnet, nicht verschwiegen. Lücken sind sichtbar und werden nicht vertuscht.

Zweck: Legen Sie das Format, die Struktur und die Qualitätskriterien fest, bevor Sie die Anfrage stellen, nicht nachdem Sie das Ergebnis gesehen haben.

Was ist zu entscheiden:

- Welches Format und welche Länge? (300 Wörter, gegliedert nach Sprint-Ziel, drei Abschnitte.)

- Was muss enthalten sein? (Abgeschlossene Punkte, nicht abgeschlossene Punkte mit Begründungen, aufgetretene Risiken.)

- Welcher Qualitätsstandard gilt? (Verwenden Sie die fünf oben genannten Kriterien als Ausgangspunkt.)

Beispiel: „250 bis 350 Wörter, gegliedert wie folgt: (A) Fortschritt des Sprintziels mit abgeschlossenen Arbeitsaufgaben, (B) nicht abgeschlossene Arbeitsaufgaben mit Begründungen, (C) während des Sprints aufgetretene Risiken. Verfasst für nichttechnische Stakeholder.“

Häufiger Fehler (Abweichung von Standards): Praktiker definieren die Erwartungen an das Ergebnis, nachdem sie das Ergebnis gesehen haben. Sie passen ihren Standard an das an, was die KI produziert hat. Sie würden niemals eine Definition of Done akzeptieren, die besagt: „Wir werden es wissen, wenn wir es sehen.“ Akzeptieren Sie das auch nicht von Ihren KI-Workflows.

4. Validierung: Wer überprüft und anhand welcher Kriterien?

Hier wird deutlich, ob Ihre Assist-Klassifizierung ehrlich oder eher ambitioniert war.

Zweck: Legen Sie fest, wie der Mensch die Ergebnisse überprüft, und trennen Sie dabei automatisierte Überprüfungen von Ermessensentscheidungen.

Was ist zu entscheiden:

- Was kann mechanisch überprüft werden? (Einhaltung der Formatierung, Länge, vorhandene erforderliche Abschnitte.)

- Was erfordert menschliches Urteilsvermögen? (Richtigkeit der Angaben, Angemessenheit für das Publikum, Kontext, über den KI nicht verfügt.)

- Was ist der Validierungsstandard? (Stichprobenprüfung einer Auswahl? Überprüfung jeder Angabe? Abgleich mit Quelldaten?)

Beispiel: „Stichprobenartige Überprüfung von 3 Elementen oder 20 % der Elemente (maximal 8) anhand des Jira-Exports. Überprüfe, ob die Liste „nicht abgeschlossen” vollständig ist. Lese die Stakeholder-Formulierung laut vor: Würdest Du dies in der Besprechung sagen? Wenn zwei oder mehr Stichproben fehlschlagen, markieren Sie das Ergebnis rot und wechseln Sie zum manuellen Fallback.”

Nicht jede Ausgabe ist bestanden oder nicht bestanden. Verwenden Sie Konfidenzniveaus, um Grauzonen zu behandeln:

- Grün: Validierungsprüfungen bestanden. Kann bedenkenlos extern veröffentlicht werden.

- Gelb: Nur für den internen Gebrauch. Wenn eine Ausgabe mit gelbem Status einen Stakeholder erreicht, handelt es sich um ein Failure Response-Ereignis. Gelb bedeutet „menschliche Überarbeitung erforderlich“, nicht „KI-ig okay“.

- Rot: Stoppregel wird ausgelöst. Wechseln Sie zum manuellen Fallback.

Häufiger Fehler (Rationalisierung von “Avoid‘ als ‚Assist‘): Wenn die Validierung schwierig ist, besteht der Instinkt darin, KI vollständig von der Aufgabe auszuschließen. Das ist zu binär. Eine schwache Validierung ist eine Designbeschränkung, kein Grund zur Vermeidung. Beschränken Sie die Aufgabe so, dass eine Validierung möglich wird: Verlangen Sie von der KI die Erstellung einer Themenkarte mit Transkript-IDs, setzen Sie die Abdeckung über alle Segmente hinweg durch, überprüfen Sie Zitate stichprobenartig anhand der Originale. Reservieren Sie ‚Avoid‘ für vertrauensintensive, beziehungsintensive Arbeiten mit hohen sozialen Konsequenzen: Leistungsfeedback, Konfliktmediation, sensible Gespräche mit Stakeholdern.

5. Reaktion auf Fehler: Was geschieht, wenn etwas nicht funktioniert?

Niemand plant für den Fall eines Fehlers, bis 10 Minuten vor der Bereitstellung, und dann wünscht sich jeder, er hätte es getan.

Zweck: Definieren Sie die Ausweichlösung, bevor Sie sie benötigen.

Was ist zu entscheiden:

- Wie lautet die Stoppregel? (Wann verwerfen Sie das KI-Ergebnis und wechseln zur manuellen Erledigung?)

- Wie weit kann sich ein Fehler ausbreiten? (Fließt dieses Ergebnis in eine andere Entscheidung ein?)

- Wer ist für die Eskalation zuständig, wenn es sich um einen systemischen Fehler handelt?

Beispiel: „Wenn die Zusammenfassung den Fortschritt des Sprintziel falsch darstellt, generiere diese mit korrigierten Eingaben neu. Wenn weniger als 10 Minuten vor der Bereitstellung Unstimmigkeiten festgestellt werden, wechsle zum manuellen Fallback: Der Scrum Master liefert direkt eine mündliche Zusammenfassung aus dem Sprint Backlog.“

Häufiger Fehler (‚Automat‘ nach dem Prinzip „Einmal einrichten und vergessen”): Teams erstellen KI-Workflows ohne manuelles Fallback. Wenn der Workflow ausfällt, weiß niemand mehr, wie die Aufgabe ohne KI zu erledigen ist. Jedes Bereitstellungs-Playbook enthält einen Rollback-Plan. Ihre KI-Workflows benötigen dasselbe.

6. Aufzeichnungen: Was protokollieren Sie?

„Dafür haben wir keine Zeit“ ist der häufigste Einwand. Dies führt auch dazu, dass Teams drei Monate später nicht mehr in der Lage sind, ihre eigenen Arbeitsabläufe zu erklären.

Zweck: Den Arbeitsablauf nachvollziehbar, erlernbar und übertragbar machen.

Was ist zu entscheiden:

- Was speichern Sie? (Prompt, Skills, Eingabedaten, KI-Ausgabe, manuelle Bearbeitungen, endgültige Version, wer hat genehmigt.)

- Wo speichern Sie es? (Team-Wiki, gemeinsamer Ordner, Projektmanagement-Tool.)

- Wem gehört das Protokoll?

Beispiel: „Speichern Sie den Prompt-Text, die Jira-Exportversion und die endgültige Stakeholder-Nachricht im Sprint-Review-Ordner des Teams. Der Scrum Master ist verantwortlich für das Protokoll.“

Häufiger Fehler (keinerlei Rückverfolgbarkeit): Der Einwand erscheint vernünftig, bis ein Stakeholder fragt: „Woher stammt diese Zahl?“, und niemand die Antwort rekonstruieren kann. Sie müssen nicht alles auf derselben Ebene protokollieren. Verwenden Sie eine Rückverfolgbarkeitsleiter:

- Ebene 1 (persönlich): Prompt oder Skill plus Endergebnis plus 3-Punkte-Checkliste, die Sie zur Validierung verwendet haben. In der Regel dauert dies etwa 2 Minuten, sobald Sie sich daran gewöhnt haben.

- Ebene 2 (Team): Fügen Sie die Eingabequelle, die Versionierung und den Genehmiger hinzu. In der Regel dauert dies etwa 5 Minuten.

- Ebene 3 (reguliert): Fügen Sie ein Schwärzprotokoll, Beweislinks und die Audit-Kadenz hinzu. Sind für compliance-sensitive Arbeitsabläufe erforderlich.

Beginnen Sie auf Ebene 1. Wechseln Sie zu einer höheren Ebene, wenn es die Umstände rechtfertigen.

Der Sprint-Review-Canvas: Von Anfang bis Ende

Angewandt auf die Zusammenfassung des Sprint Reviews durch den Scrum Master:

- Aufgabenteilung: AI erstellt Entwürfe; Scrum Master finalisiert; Product Owner überprüft aus Sicht der Stakeholder.

- Inputs: Jira-Export (aktueller Sprint) + Sprintziel + Sprint-Backlog-Deltas und Hindernisse.

- Ergebnisse: 250 bis 350 Wörter; Abschnitte: Zielfortschritt / Nicht abgeschlossen / Risiken.

- Validierung: Stichprobenprüfung max. (3 bzw. 20 % der Elemente); Überprüfung auf fehlende Risiken; lautes Vorlesen der Formulierung.

- Fehlerbehandlung: Bei Unstimmigkeiten: neu generieren. Weniger als 10 Minuten bis zum Abgabetermin: manuelle mündliche Zusammenfassung.

- Aufzeichnungen: Prompt/Skill + Jira-Exportversion + endgültige Nachricht im Sprint-Review-Ordner gespeichert.

Warum der A3-Handoff-Canvas über Ihre eigene Praxis hinaus von Bedeutung ist

Im AI4Agile Practitioner Report 2026 nannten 54,3 % der Befragten Integrationsunsicherheit als ihre größte Herausforderung bei der Einführung von KI [2]. Es handelt sich hierbei nicht um Widerstand gegen KI oder die Qualität der Tools, sondern um die Ungewissheit, wie KI in bestehende Arbeitsabläufe integriert werden kann. Der A3-Handoff-Canvas geht diese Unsicherheit auf Teamebene an: Es verwandelt „Wir experimentieren mit KI” in „Wir haben einen definierten Workflow für KI-gestützte Sprint-Review-Zusammenfassungen, und jeder im Team kann ihn ausführen”.

Ein ausgefüllter A3-Handoff-Canvas wird zu einem organisatorischen Aktivposten. Wenn ein Scrum Master das Unternehmen verlässt, dokumentieren die Canvases, wie KI in die Arbeitsabläufe integriert ist. Wenn neue Teammitglieder hinzukommen, erkennen sie vom ersten Tag an die Grenzen zwischen menschlichem Urteilsvermögen und KI. Wenn die Führungsebene fragt: „Wie nutzt das Team KI?”, liefern die Canvases eine glaubwürdige Antwort.

Die Ebenen interagieren jedoch miteinander. Ein Team mit einem ausgezeichneten A3-Handoff-Canvas, aber ohne organisatorische Datenklassifizierungsrichtlinie wird bei den Inputs an seine Grenzen stoßen. Eine Organisation mit einer umfassenden KI-Richtlinie, aber ohne Canvas auf Teamebene wird Governance nur auf dem Papier erfüllen, in der Praxis jedoch Chaos erfahren. Außerdem geben 14,2 % der Praktiker an, überhaupt keine organisatorische KI-Unterstützung zu erhalten [2]. Wenn dies auf Ihre Situation zutrifft, ist der A3-Handoff-Canvas nicht optional. Es ist Ihre minimal realisierbare Governance, bis Ihre Organisation aufgeholt hat.

Fazit: Probieren Sie den A3-Handoff-Canvas diese Woche an einem Workflow aus.

Wählen Sie einen KI-Workflow aus, den Sie in jedem Sprint wiederholen. Notieren Sie die sechs Elemente. Füllen Sie sie ehrlich aus. Fragen Sie dann Ihr Team: Entspricht dies unserer Arbeitsweise oder haben wir bisher auf impliziten Annahmen basiert?

Wenn Sie bei der Validierung oder der Reaktion auf Fehler nicht weiterkommen, haben Sie die Schwachstelle gefunden, bevor diese Sie findet.

Litatur

[1] Dell’Acqua, F., Ayoubi, C., Lifshitz, H., Sadun, R., Mollick, E., Mollick, L., Han, Y., Goldman, J., Nair, H., Taub, S., and Lakhani, K.R. (2025). „The Cybernetic Teammate: A Field Experiment on Generative AI Reshaping Teamwork and Expertise.“ Harvard Business School Working Paper 25-043.

[2] Wolpers, S., and Bergmann, A. (2026). „AI for Agile Practitioners Report.“ Berlin Product People GmbH.

🗞 Shall I notify you about articles like this one? Awesome! You can sign up here for the ‘Food for Agile Thought’ newsletter and join 35,000-plus subscribers.